Im Onlinemarketing und speziell im Bereich der Conversionoptimierung (CRO) sind AB-Tests eines der wichtigsten Werkzeuge, um den Umsatz zu steigern.

Mit einem AB-Test lässt sich super herausfinden, welche Variante von einer Produktseite, Newsletter oder Anzeige besser bei meiner Zielgruppe ankommt. Allerdings ist eine vernünftige Testdurchführung das eine, die Interpretation der Ergebnisse hingegen etwas ganz anderes. Berufsbedingt habe ich oft mit AB-Tests und Email-Marketing zu tun. Da treten regelmäßig die gleichen Fragen hinsichtlich der Auswertung und Interpretation von AB-Tests auf. In diesem Artikel geht es um die Frage: Wie ermittle ich die Gewinnervariante eines AB-Testings? Die Frage mutet zunächst lächerlich einfach an. Aber das ist sie mitnichten.

Was ist ein AB-Test?

In einer idealen Welt würde ein AB-Test zu einem eindeutigen Ergebnis führen, sodass es einen klaren Gewinner gibt. Nun ist die echte Welt leider nicht so einfach. In vielen Bereichen sind mehrere Kanäle an einer Conversion beteiligt, die jeweils ihren eigenen Gesetzen und Metriken folgen. Ein AB-Test über mehrere Kanäle hinweg ist daher eine hohe Kunst, insbesondere wenn der Test nicht am Ende, sondern am Anfang oder in der Mitte der Customer Journey stattfindet. In diesem Fall gibt es verschiedene Punkte, wo ein Nutzer sich noch gegen die Conversion entscheiden kann, die nichts mehr mit dem AB-Test zu tun haben.

Entsprechend gibt es auch nicht die eine Conversionrate. Vielmehr gibt es viele – je nach Bereich innerhalb der Customer Journey – verschiedene “Conversionrates” und alle führen im schlimmsten Fall zu unterschiedlichen Ergebnissen.

Beispiel AB-Test mit und ohne künstlicher Verknappung

Am besten versteht man so etwas an einem praktischen Beispiel. Stellen wir uns vor, dass wir einen Newsletter-AB-Test durchführen, bei dem Variante A eine künstliche Verknappung enthält. In dieser Variante erhalten Kunden innerhalb der nächsten 3 Tage einen Rabatt von ca. 20%. Die Kontrollgruppe aus Variante B erhält einen Newsletter, der zwar ebenfalls den Rabatt anbietet, aber zeitlich keine Beschränkung und damit keine Dringlichkeit auslöst. Bei einem Click auf den Kaufen-Button wird der der potentielle Kunde direkt zum Checkout der Shopwebsite geleitet. Um es nochmal ganz klar zu machen: Der Unterschied liegt allein in dieser Grafik innerhalb des Newsletters. Die Betreffzeilen sind identisch, die Empfänger gut durchgemischt und auch der Shop mit seinem Checkout, wo das Produkt letztlich gekauft wird, ist in beiden Varianten identisch.

Am besten versteht man so etwas an einem praktischen Beispiel. Stellen wir uns vor, dass wir einen Newsletter-AB-Test durchführen, bei dem Variante A eine künstliche Verknappung enthält. In dieser Variante erhalten Kunden innerhalb der nächsten 3 Tage einen Rabatt von ca. 20%. Die Kontrollgruppe aus Variante B erhält einen Newsletter, der zwar ebenfalls den Rabatt anbietet, aber zeitlich keine Beschränkung und damit keine Dringlichkeit auslöst. Bei einem Click auf den Kaufen-Button wird der der potentielle Kunde direkt zum Checkout der Shopwebsite geleitet. Um es nochmal ganz klar zu machen: Der Unterschied liegt allein in dieser Grafik innerhalb des Newsletters. Die Betreffzeilen sind identisch, die Empfänger gut durchgemischt und auch der Shop mit seinem Checkout, wo das Produkt letztlich gekauft wird, ist in beiden Varianten identisch.

Was ist eine Conversionrate?

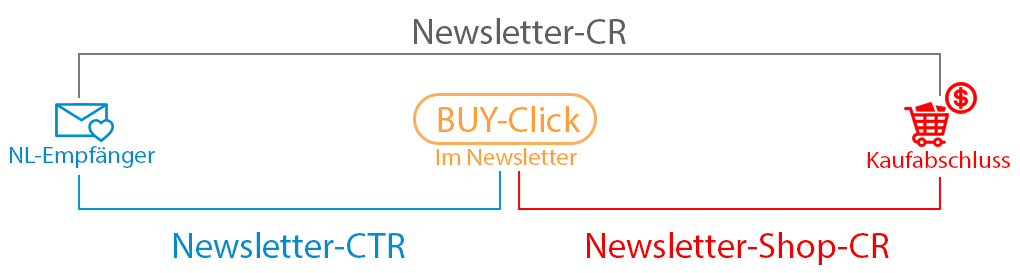

Das Wort “Conversionrate” wird oft benutzt und ist dennoch nicht einheitlich. Was man darunter versteht kann sehr unterschiedlich sein. Entsprechend unklar ist, welche “Conversionrate” man als KPI bei einem Newsletter-AB-Test heranzieht.

Misst man einfach nur die Newsletter-Conversionrate (in der Grafik grau)? Also das Verhältnis von Newsletter-Empfängern zu Shop-Verkäufen? Oder die Newsletter-CTR (in der Grafik blau), die Aufschluss über die Empfänger im Verhältnis zu den Kaufen-Clicks im Newsletter stehen. Man könnte letztlich auch nur die Newsletter-Shop-CR (in der Grafik rot) betrachten. Damit meine ich, wie viele der Leute, die den Kaufen-Button im Newsletter geklickt haben, sind letztlich auch im Shop konvertiert und haben den Kauf abgeschlossen. Aus meiner Sicht ist es wichtig, dass man sich im Team austauscht und festlegt, welche KPI man als Conversionrate bezeichnen möchte.

Die Auswertung und Interpretation eines AB-Tests

Der wichtigste Teil hat mit dem Punkt vorher zu tun. Ich muss mir die Frage stellen, welche Teilabschnitt der Customer Journey ich zur Erfolgsauswertung bei einem AB-Test heranziehen möchte. Mir kommen da spontan zwei unterschiedliche Ansätze in den Sinn:

- Ich betrachte die Newsletter-CTR, also die Anzahl der unique Klicks auf den Kaufen-Button im Newsletter im Verhältnis zu den Empfängern. Hintergrund dieses Gedankens: Der AB-Test spielt sich innerhalb des Newsletters ab. Alles was vorher und später im Warenkorb passiert, entzieht sich meiner Kontrolle und sollte im Idealfall sowieso während des Tests nicht geändert werden und daher keinen Einfluss haben.

- Ich betrachte die Newsletter-CR und wähle damit die Variante, die absolut gesehen mehr Umsatz generiert hat, unabhängig davon wie viele Leute auf den Kaufen-Button im Newsletter geklickt haben. Ich schau also, was ist am Ende des Tages hinten raus gekommen.

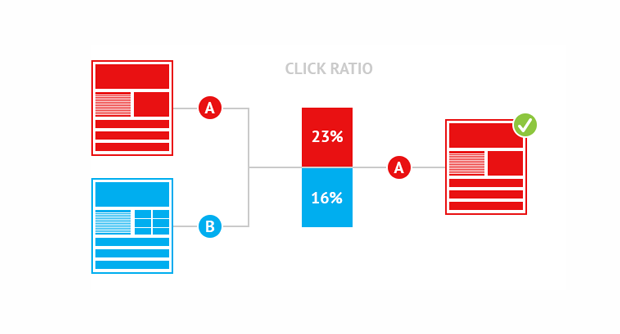

Warum es sinnvoll ist, sich mit dieser Fragestellung zu beschäftigen, macht folgende Grafik deutlich.

Beide Ansätze haben verschiedene Vor- und Nachteile. In der Theorie müsste der Ansatz mit der Newsletter-CTR der Beste, weil Sauberste sein. Schaut man sich hingegen die Newsletter-CR und die absoluten Zahlen an, stellt man fest, dass Trotz der 9400 Clicks in Newsletter Variante B am Ende nur 2000 Sales generiert werden konnten. Wohingegen Variante A trotz weniger Clicks am Ende 300 Sales mehr erzielt hat, als Variante B.

Hätte man sich nur für Newsletter-CTR angesehen, hätte man sich am Ende für die Variante entschieden, die weniger Geld bringt. Das mag verwirrend sein, weil es unsere ideale AB-Tester-Welt viel komplizierter macht. Und in der Tat kommt so ein Ergebnis öfter vor, als man zunächst denken würde. Ich führe bei uns pro Jahr Dutzende AB-Test durch und würde aus dem Bauch heraus sagen, dass in ca. 50% der Fälle so ein Phänomen auftritt.

Wie ist das zu erklären?

Über dieses Problem habe ich viel nachgedacht und habe einen psychologischen Lösungsansatz gefunden, der sich jedoch nicht eindeutig überprüfen lässt.

Wir erinnern uns: Ausgangspunkt der Überlegung war es ja, dass der AB-Test nur im Newsletter stattfindet. Alles was anschließend im Checkout des Shops passiert ist wieder identisch und sollte daher keinen Einfluss haben. Leider zeigt die Realität, dass die Zahlen teilweise doch deutlich voneinander abweichen. Ich erkläre mir das so: Insbesondere wenn wir bei einem AB-Test im Newsletter mit psychologischen Mechanismen arbeiten, lösen wir beim potentiellen Kunden ein bestimmtes Verhalten aus. Dieses Verhalten hat seinen Ursprung im Gehirn. Wir können davon ausgehen, dass es dem Gehirn relativ Schnuppe ist, ob es einen technischen Unterschied zwischen Newsletter und Warenkorb gibt. Mit anderen Worten: Durch persuasive Kommunikation lösen wir ein Verhalten aus, dass nicht nur im Newsletter wirkt, sondern darüber hinaus auch noch im Warenkorb weiterhin anhält.

In unserem Beispiel haben wir in Variante A als persuasive Botschaft die Mechanik der Verknappung eingesetzt. Psychologisch gesehen steht dahinter die Reaktanztheorie. Im Gehirn des potenzielle Käufer erscheint das Produkt durch die Verknappung noch begehrenswerter und sie wissen, dass sie sich beeilen müssen, um das Angebot nicht zu verpassen. Dieser Effekt lässt das rationale Denken kurzfristig aussetzen und kann daher auch noch den Bestellprozess im Checkout überdauern.

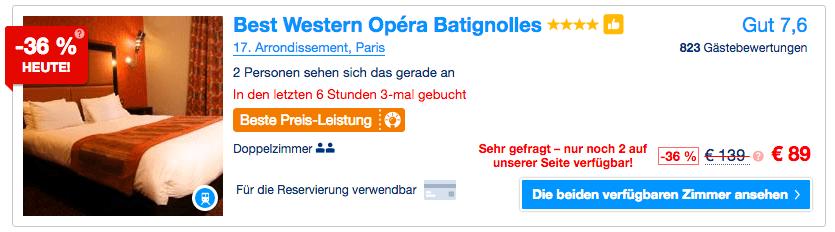

Es kann soweit gehen, dass der Preis vollständig in den Hintergrund rückt und es nur noch darum geht, das Produkt zu bekommen, bevor das Angebot nicht mehr verfügbar ist. Dieses Verhalten lässt sich in Verbindung mit dem Mechanismus des Social Proof noch weiter steigern. So gesehen bei Booking.com. Hier wird dem interessierten Besucher gesagt: “ Achtung: Es sind nur noch 2 Zimmer verfügbar, und es wurden in den letzten 6 Stunden 3 Zimmer in diesem Hotel gebucht.” Zusätzlich wird die Dringlichkeit durch den Zusatz “2 Personen sehen sich das gerade an” erzeugt.

Fazit

AB-Testings können ordentliche Umsatzsteigerungen bringen – wenn Vorbereitung, Durchführung und Analyse stimmen. Was sich im ersten Moment einfach anhört gestaltet sich in der Praxis oftmals gar nicht so leicht und erfordert etwas Gehirnschmalz und Erfahrung. Daher gibt es auch bei der Wahl der richtigen KPI hinsichtlich der Messgröße keine einheitliche Empfehlung, sondern es kommt auf den Einzelfall an. Wir nutzen bei uns derzeit die vorher beschriebene NL-CR, die auch den Warenkorb mit einbezieht, weil wir eher eine ganzheitliche Betrachtung durchführen. Übrigens lässt sich alles, was hier in diesem Artikel steht auch auf andere Performancekanäle wie z.B. SEM übertragen, auch wenn dort die Möglichkeiten für persuasive Botschaften etwas beschränkter sind.

Mich würde interessieren, wie ihr darüber denkt. Wie geht ihr bei AB-Tests vor und sollte man nur den Ort des AB-Tests betrachten oder das große Ganze? Schreibts in die Kommentare!

Ich bin Marcel Gabor und beschäftige mich seit über 10 Jahren mit Online-Marketing. Beruflich und hier im Blog dreht sich alles um Online-Marketing, sowie Conversion-Optimierung. Zusätzlich spreche ich verschiedene psychologische Effekte im Kontext von Konsumentenverhalten an.

Ich bin Marcel Gabor und beschäftige mich seit über 10 Jahren mit Online-Marketing. Beruflich und hier im Blog dreht sich alles um Online-Marketing, sowie Conversion-Optimierung. Zusätzlich spreche ich verschiedene psychologische Effekte im Kontext von Konsumentenverhalten an.

Danke für den Beitrag, Marcel 🙂

Ich hoffe, dass der Blog noch weitergeführt wird